类别不平

-

AI模型在边缘案例与特定群体表现不佳?量化分析与技术选型指南

作为一名技术出身的AI产品经理,你一定深知AI模型在通用场景下表现优异,但在特定边缘案例或群体上却可能“掉链子”的痛点。尤其是在那些对准确性和公平性要求极高的关键应用领域,模型性能的不一致性不仅会影响用户体验,更可能导致严重的信任危机。面...

-

不同损失函数对目标检测影响的深度解析

在目标检测领域,损失函数的选择对模型的性能有着至关重要的影响。本文将深入探讨不同损失函数对目标检测的影响,分析其优缺点,并提供一些实际应用中的案例。 1. 损失函数概述 损失函数是深度学习模型中用于衡量预测结果与真实值之间差异的函...

-

机器学习:从“被动救火”到“主动预警”的网络安全新范式

机器学习:从“被动救火”到“主动预警”的网络安全新范式 在日益复杂的网络安全环境中,传统的基于规则和特征码的防御体系常常陷入“被动救火”的窘境。海量的安全告警、不断变种的攻击手段、层出不穷的零日漏洞,让安全团队疲于奔命。然而,随着机器...

-

AUC值与其他评估指标的比较:如何选择合适的模型评估方法

在机器学习领域,模型评估是一个至关重要的环节。不同的评估指标可以帮助我们更好地理解模型的性能。本文将重点讨论AUC值(Area Under the Curve)及其与其他评估指标的比较,帮助读者选择合适的模型评估方法。 什么是AUC值...

-

AI缺陷检测:GAN与VAE如何破解工业数据稀缺与复杂背景难题?

在工业生产线上,缺陷检测是确保产品质量的关键环节。然而,我们团队在实践中经常遇到一个棘手的问题: 工业缺陷样本极其罕见,且图像背景复杂多变。 这导致训练出的AI模型在检测精度和召回率上难以达到生产要求。传统的增广方法往往无法有效应对这种...

-

别让数据偏见毁了你的图像识别模型:嵌套交叉验证与数据增强组合拳

引言:当你的模型只认识“大多数” 搞图像识别的你,是不是经常遇到这种情况:训练数据里,猫狗图片一大堆,但你想识别的某种罕见鸟类或者特定病理切片,图片却少得可怜?这就是典型的**类别不平衡(Class Imbalance)**问题。直接...

-

迁移学习模型:如何评估其性能?

迁移学习模型:如何评估其性能? 迁移学习,顾名思义,就是将一个任务上训练好的模型应用到另一个相关但不同的任务上。它可以有效地解决数据稀缺问题,在许多领域都取得了显著的成果。但如何评估迁移学习模型的性能,成为了一个重要的议题。 评估...

-

分类不平衡问题对模型有什么影响?

**问题:**在机器学习和数据科学领域,我们经常遇到一种称为"类别不平衡"的情况。这意味着在数据集中,某些类别的实例比其他类别的实例更为常见。这种不平衡会对模型的性能和预测能力产生怎样的影响? 影响: ...

-

嵌套交叉验证:应对类别不平衡问题的终极指南

大家好,我是老码农。今天咱们来聊聊机器学习中一个非常棘手的问题——类别不平衡。这个问题就像是考试时偏科一样,严重影响了模型的整体表现。但别担心,我将带你深入了解嵌套交叉验证(Nested Cross-Validation),以及它在处理类...

-

如何处理类别不平衡问题?

在机器学习和数据分析领域,类别不平衡问题是指数据集中某些类别的样本数量远多于其他类别,导致模型训练偏向多数类别,难以准确识别少数类别。这在医学诊断、金融欺诈检测等领域尤为常见。 处理方法: 数据采样 :包括过采样和欠采样,改...

-

如何使用SMOTE算法处理房价数据中的类别不平衡问题?

在数据科学领域,处理类别不平衡问题是一个常见的挑战,特别是在房价预测这类回归问题中。我们在使用机器学习模型时,往往会遇到房价数据中某些类别(如高价房源)样本稀少,而其他类别样本过多的情况。为了有效解决这一问题,可以考虑采用SMOTE(合成...

-

基于深度学习的蜂群识别算法优化:如何在复杂环境下提升精度和实时性?

基于深度学习的蜂群识别算法优化:如何在复杂环境下提升精度和实时性? 蜂群识别在农业、生态监测等领域具有重要意义。传统方法难以应对复杂环境下的挑战,而深度学习技术的兴起为蜂群识别带来了新的机遇。然而,如何提升深度学习算法在复杂环境下的精...

-

机器学习模型选择中的AUC指标:全面解析与实际应用

机器学习模型选择中的AUC指标:全面解析与实际应用 在机器学习领域,模型评估是至关重要的一环。选择合适的评估指标可以帮助我们更好地理解模型的性能,从而选择最优的模型。AUC指标(Area Under the Curve)作为一种常用的...

-

如何评估不同模型的性能?

在机器学习和数据科学领域,模型的性能评估是一个至关重要的环节。无论是分类模型还是回归模型,评估其性能的方式都直接影响到我们对模型的理解和应用。 1. 模型评估的基本概念 模型评估是指通过一定的指标和方法来判断模型在特定任务上的表现...

-

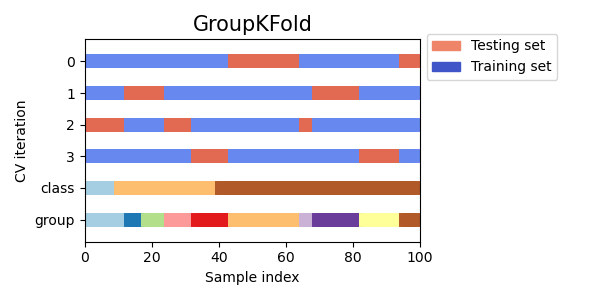

交叉验证详解:K折、分层K折与留一法,选对才靠谱

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢...

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢... -

常见的数据偏斜场景及其解决方案

数据偏斜是什么? 数据偏斜是指数据分布不均匀或有偏差的现象,它常见于机器学习和数据科学领域。这种偏斜可能出现在不同的维度中,如类别、特征或样本之间。例如: 类别不平衡 :在分类问题中,一个类别的样本数量远多于另一个类别。例如...

-

房价预测模型的类别不平衡问题:如何解决样本倾斜的难题?

房价预测模型的类别不平衡问题:如何解决样本倾斜的难题? 房价预测一直是机器学习领域一个热门的研究课题,但实际应用中常常面临一个棘手的问题:数据不平衡。通常情况下,高房价区域的样本数量远大于低房价区域,导致模型训练过程中出现 类别不平衡...

-

DBSCAN参数选择与DBSCAN+LSTM模型性能评估实战指南

你好!在数据挖掘和机器学习的世界里,DBSCAN(Density-Based Spatial Clustering of Applications with Noise)因其能发现任意形状簇、对噪声点不敏感而备受青睐。而LSTM(Long...

-

深度学习模型性能评估指标及其瓶颈:从准确率到鲁棒性

深度学习模型的性能评估一直是该领域的核心问题之一。仅仅依靠简单的准确率指标已经不足以全面衡量一个模型的优劣,我们需要更细致、更全面的评估体系来判断模型的实际应用价值。本文将探讨深度学习模型性能评估的常用指标,并深入分析其局限性以及可能存在...

-

深入了解AUC和ROC曲线:它们的作用与其他评估指标的比较

在机器学习和数据科学领域,模型评估是一个至关重要的环节。AUC(Area Under the Curve)和ROC(Receiver Operating Characteristic)曲线是评估分类模型性能的常用工具。本文将深入探讨AUC...