超参数搜索

-

GPU集群任务可视化:告别“盲盒式”等待,让你的AI实验尽在掌握

在AI/ML研发的快节奏环境中,GPU集群已成为支撑模型训练和实验的关键基础设施。然而,许多研究员和工程师可能都经历过这样的困境:提交了一批超参数搜索或模型对比任务后,只能“听天由命”,反复通过命令行查询任务状态,不仅效率低下,还白白浪费...

-

利用TensorFlow提升超参数搜索效率的实用指南

在机器学习和深度学习的模型训练过程中,超参数的选择至关重要。超参数指的是在模型训练之前设定的参数,比如学习率、批次大小、层数等,这些参数直接影响模型的性能。然而,手动调整这些超参数耗时且效率低下,因此许多研究者开始寻求更有效的超参数优化方...

-

比较随机森林搜索与贝叶斯优化对超参数优化的影响

在机器学习模型的训练中,超参数优化一直是一个至关重要的步骤。尤其是在使用像随机森林这样复杂的模型时,如何选择最佳的超参数,以达到最佳的预测效果,成为了许多数据科学家需要面对的问题。 随机森林与超参数优化 随机森林作为一种集成学习方...

-

AI炼丹师的痛:如何打造公平高效的GPU资源调度系统

作为一名深度学习工程师,我深有体会,每次模型训练前,最让人心焦的不是算法设计有多复杂,也不是数据预处理有多繁琐,而是那漫长而又不可预测的GPU资源排队等待。有时候,一个实验任务需要排队一整天,眼睁睁看着GPU闲置却无法启动自己的任务,那种...

-

AI场景下GPU资源优化:平衡深度学习训练与在线服务稳定性的策略与实践

在AI大行其道的今天,GPU已成为支撑深度学习训练和推理的核心算力。然而,作为AI基础设施的负责人,我深知平衡团队内部深度学习工程师对GPU资源“永不满足”的需求,与在线服务必须保障的稳定性,是一个长期且棘手的挑战。工程师们抱怨训练任务排...

-

嵌套交叉验证:获取可靠模型性能评估的终极武器

引言:超参数调优与模型评估的困境 在机器学习实践中,模型的性能很大程度上取决于超参数的选择。比如支持向量机(SVM)中的 C 和 gamma ,随机森林中的 n_estimators 和 max_depth 等等。找到最...

-

别让数据偏见毁了你的图像识别模型:嵌套交叉验证与数据增强组合拳

引言:当你的模型只认识“大多数” 搞图像识别的你,是不是经常遇到这种情况:训练数据里,猫狗图片一大堆,但你想识别的某种罕见鸟类或者特定病理切片,图片却少得可怜?这就是典型的**类别不平衡(Class Imbalance)**问题。直接...

-

Grid Search VS. Random Search:实战案例剖析与代码演示

Grid Search VS. Random Search:实战案例剖析与代码演示 在机器学习模型训练中,超参数调优至关重要。它直接影响模型的性能和泛化能力。常用的超参数搜索方法包括Grid Search和Random Search。...

-

如何在PyTorch中高效地进行超参数搜索?

在深度学习领域,选择合适的超参数对模型性能至关重要。而在使用PyTorch框架时,我们能够通过多种方式来高效地进行这些设置。在这篇文章中,我将为你详细介绍如何在PyTorch中实现高效的超参数搜索,确保你的模型能达到最佳表现。 1. ...

-

嵌套交叉验证:应对类别不平衡问题的终极指南

大家好,我是老码农。今天咱们来聊聊机器学习中一个非常棘手的问题——类别不平衡。这个问题就像是考试时偏科一样,严重影响了模型的整体表现。但别担心,我将带你深入了解嵌套交叉验证(Nested Cross-Validation),以及它在处理类...

-

模型调优炼金术 深度揭秘嵌套交叉验证中的超参寻优与结果分析

模型调优炼金术:深度揭秘嵌套交叉验证中的超参寻优与结果分析 嘿,老铁们,我是老码农,一个在算法世界里摸爬滚打了十几年的老家伙。今天,咱们不聊那些虚头巴脑的理论,来点实在的,聊聊咱们在模型调优,特别是嵌套交叉验证(Nested Cros...

-

K折交叉验证:K值选择的艺术与科学 - 偏见、方差与计算成本的权衡

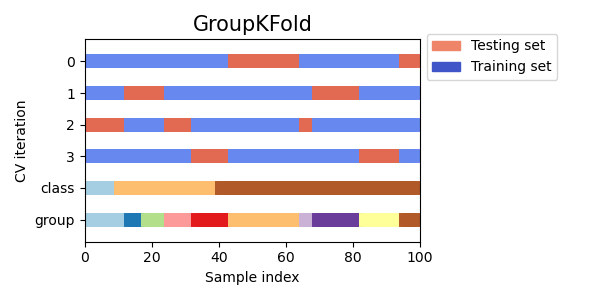

K折交叉验证:K值怎么选才靠谱? 在机器学习模型开发中,评估模型的泛化能力至关重要。我们希望模型在没见过的数据上也能表现良好,而不是仅仅拟合训练数据。K折交叉验证(K-Fold Cross-Validation)是实现这一目标最常用、...

-

模型训练度和特殊选择之谜:如何影响模型的泛化能力?

模型训练度和特殊选择之谜:如何影响模型的泛化能力? 在深度学习中,模型训练度和特殊选择是两个至关重要的因素,它们直接影响着模型的泛化能力。泛化能力是指模型在训练集之外的数据集上表现的能力,是衡量模型实际应用价值的关键指标。 模型训...

-

交叉验证详解:K折、分层K折与留一法,选对才靠谱

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢...

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢... -

深入理解 Isolation Forest:核心超参调优与实战案例

大家好,我是老K,今天咱们聊聊异常检测领域的一个明星算法——Isolation Forest(孤立森林)。这玩意儿特别好用,尤其是在处理高维数据和大规模数据集的时候。它不仅速度快,而且效果还不错,简直是异常检测的利器。 今天,咱们不玩...

-

机器学习进阶:嵌套交叉验证在特征选择中的实战指南

你好,我是老码农。今天我们来聊聊机器学习中一个非常重要但容易被忽视的环节——特征选择,以及如何结合嵌套交叉验证(Nested Cross-Validation)来优雅地解决特征选择和模型评估的问题。对于经常需要同时处理特征工程和模型调优的...

-

嵌套交叉验证调优避坑指南:内循环超参数搜索选型与实践

搞机器学习模型的同学,肯定都绕不开超参数调优这个环节。学习率、正则化强度、树的深度...这些超参数的设置,直接关系到模型的最终性能。但怎么才算找到了“好”的超参数呢?更重要的是,怎么评估模型在这些“好”超参数下的真实泛化能力? 很多人...

-

超参数调优:榨干YOLOv5的最后一滴性能

超参数调优:榨干YOLOv5的最后一滴性能 YOLOv5作为一款优秀的实时目标检测模型,凭借其速度和精度优势赢得了广泛的关注。然而,想要真正发挥YOLOv5的潜力,超参数调优是必不可少的环节。本文将深入探讨如何通过超参数调优来提升YO...