计算成本

-

如何评估对抗样本的攻击效果?常用的评估指标有哪些?

如何评估对抗样本的攻击效果?常用的评估指标有哪些? 对抗样本攻击是近年来深度学习领域面临的一个重要安全挑战。对抗样本是指通过对原始样本添加微小的扰动,从而导致模型产生错误预测的样本。评估对抗样本的攻击效果,对于理解攻击的有效性和防御方...

-

推荐系统:平衡主流与长尾,实现“千人千面”的成本高效策略

在互联网产品,尤其是内容和电商平台中,推荐系统扮演着至关重要的角色。然而,如何巧妙地平衡主流用户的“高效利用”与长尾用户的“探索发现”,同时实现“千人千面”的深度个性化并有效控制计算成本,这确实是许多产品经理和技术团队面临的核心挑战。 ...

-

嵌套交叉验证:获取可靠模型性能评估的终极武器

引言:超参数调优与模型评估的困境 在机器学习实践中,模型的性能很大程度上取决于超参数的选择。比如支持向量机(SVM)中的 C 和 gamma ,随机森林中的 n_estimators 和 max_depth 等等。找到最...

-

深度学习模型训练中的计算成本问题及优化策略

在当今人工智能领域,深度学习已经成为了推动技术进步的重要力量。然而,在实际操作过程中,我们经常会面临一个棘手的问题:计算成本。 1. 什么是计算成本? 简单来说,计算成本指的是在模型训练和推理过程中所需消耗的时间、内存与金钱。随着...

-

孤立森林(Isolation Forest)缺失值处理:策略、实战与影响深度解析

嘿,各位跟数据打交道的朋友们!今天我们来聊聊一个在异常检测领域挺火的模型——孤立森林(Isolation Forest,简称 iForest),以及一个让无数数据分析师头疼的问题: 缺失值 。当这两者相遇,会擦出什么样的“火花”?我们又该...

-

ADBO 实战:超参数调优、黑盒函数优化与材料科学中的应用案例详解

ADBO 实战:超参数调优、黑盒函数优化与材料科学中的应用案例详解 嘿,大家好!今天咱们来聊聊自适应设计与贝叶斯优化(Adaptive Design and Bayesian Optimization,简称 ADBO)在实际应用中的那...

-

模型选择的“照妖镜” 交叉验证与信息准则的实战指南

作为一名在技术领域摸爬滚打多年的老鸟,我深知模型选择的重要性。一个好的模型,就像一把锋利的剑,能助你披荆斩棘;而一个糟糕的模型,则可能让你陷入泥潭,浪费时间和资源。在浩瀚的模型世界里,如何挑选出最适合自己的那个?今天,我就来和大家聊聊模型...

-

业务狂飙下云成本失控?计算与存储服务降本增效实用攻略

公司业务快速增长是令人欣喜的,但随之而来的云服务开销飙升,也确实让技术团队面临不小的成本压力。尤其是老板点名要控制成本,而我们又必须在不影响用户体验和系统稳定性的前提下完成任务,这确实是个棘手但必须解决的问题。 在云服务的众多开销中,...

-

MLOps实战:自动化KNN Imputer最优策略评估与选择流水线

处理数据中的缺失值是机器学习项目中绕不开的一环。各种插补方法里,KNN Imputer 因其利用邻近样本信息进行插补的特性,在某些场景下表现优于简单的均值或中位数填充。但问题来了,KNN Imputer 的效果很大程度上取决于其参数设置,...

-

zk-SNARK 深度应用:区块链、身份验证与性能安全考量

zk-SNARK:零知识证明技术的应用之旅 嗨,我是老码农,今天咱们聊聊 zk-SNARK,一个在技术圈里火得不要不要的词儿。虽然它听起来有点“高大上”,但说白了,就是一种能证明你做了某件事,但又不会泄露任何关于这件事细节的技术。这玩...

-

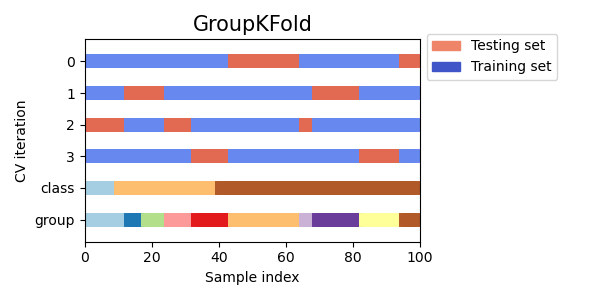

K折交叉验证:K值选择的艺术与科学 - 偏见、方差与计算成本的权衡

K折交叉验证:K值怎么选才靠谱? 在机器学习模型开发中,评估模型的泛化能力至关重要。我们希望模型在没见过的数据上也能表现良好,而不是仅仅拟合训练数据。K折交叉验证(K-Fold Cross-Validation)是实现这一目标最常用、...

-

模型评估不再飘忽不定 重复K折交叉验证详解

引言:模型评估中的“随机性”困扰 嗨,各位奋战在机器学习前线的朋友们!咱们在训练模型时,评估其性能是个绕不开的关键环节。我们常常使用交叉验证(Cross-Validation, CV),特别是K折交叉验证(K-Fold CV),来估计...

-

交叉验证详解:K折、分层K折与留一法,选对才靠谱

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢...

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢... -

深入理解 Isolation Forest:核心超参调优与实战案例

大家好,我是老K,今天咱们聊聊异常检测领域的一个明星算法——Isolation Forest(孤立森林)。这玩意儿特别好用,尤其是在处理高维数据和大规模数据集的时候。它不仅速度快,而且效果还不错,简直是异常检测的利器。 今天,咱们不玩...

-

零知识证明在区块链中的应用:安全、隐私与未来的挑战

零知识证明在区块链中的应用:安全、隐私与未来的挑战 区块链技术以其去中心化、透明和安全等特性,备受关注。然而,区块链的公开透明也带来了一些挑战,例如用户隐私的保护。零知识证明(Zero-Knowledge Proof,ZKP)作为一种...

-

机器学习进阶:嵌套交叉验证在特征选择中的实战指南

你好,我是老码农。今天我们来聊聊机器学习中一个非常重要但容易被忽视的环节——特征选择,以及如何结合嵌套交叉验证(Nested Cross-Validation)来优雅地解决特征选择和模型评估的问题。对于经常需要同时处理特征工程和模型调优的...

-

探索贝叶斯优化在对抗性机器学习中的应用:构建更鲁棒的AI模型

在人工智能领域,对抗性机器学习(Adversarial Machine Learning)已经成为一个备受关注的焦点。随着深度学习模型的广泛应用,我们发现这些模型在面对微小、精心设计的输入扰动时,往往会产生错误的预测。这种现象被称为对抗攻...

-

嵌套交叉验证调优避坑指南:内循环超参数搜索选型与实践

搞机器学习模型的同学,肯定都绕不开超参数调优这个环节。学习率、正则化强度、树的深度...这些超参数的设置,直接关系到模型的最终性能。但怎么才算找到了“好”的超参数呢?更重要的是,怎么评估模型在这些“好”超参数下的真实泛化能力? 很多人...

-

用贝叶斯优化调教GAN生成器:让你的AI画出更惊艳的图像

GAN调参的痛,贝叶斯优化来拯救? 玩过生成对抗网络(GAN)的哥们儿都知道,这玩意儿效果惊艳,但训练起来简直是门玄学。生成器(Generator)和判别器(Discriminator)的爱恨情仇,动不动就模式崩溃(mode coll...

-

深度学习框架选型指南:如何降低计算成本?

深度学习框架选型指南:如何降低计算成本? 深度学习的飞速发展离不开强大的计算能力支撑,然而高昂的计算成本常常成为研究和应用的瓶颈。选择合适的深度学习框架,能够有效降低计算成本,提高资源利用效率。本文将从多个维度探讨深度学习框架的选择,...